英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

中文译文

P-CNN: 增强文本处理与位置卷积神经网络

杨松,秦民,胡薇薇,梁河

摘要

近年来,位置信息在文本处理的深度神经网络中得到了很好的应用。大多数位置深度神经网络都是基于单词级的m atching信号来进行位置信息的提取,而在m atching分数的生成过程中,对位置影响和长文本的交互作用还没有得到很好的研究。本文提出了一种新的位置卷积神经网络模型,该模型从多个角度考虑位置影响和相互作用。具体来说,我们首先在单词级、短语级和句子级对位置信息的透视图进行编码。定义了一个位置-sim ilarity m研磨层,将字级位置信息投射到本地m atching信号上,该层连接单词em层的输入层与隐藏的tional层之间的间隙。在此基础上,提出了一种位置感知卷积滤波器,用于捕获和提取短语级和句子级的位置信息。特别地,我们假设一个短语或句子对它的相邻短语或句子有影响,并且位置敏感卷积滤波器是在影响传播的基础上生成的,而不是像传统卷积神经网络中那样随机生成一个m心房。最后,我们提供了一个多视角m atching函数来聚合单词级、短语级和句子级的位置信息。我们使用了三个标准数据集来评估我们的方法,分别是用于web搜索的nam ely ClueWeb-09-Cat-Bfor和用于选择答案的TREC-QAand WikiQAfor。值得注意的是,我们在ClueWeb-09-Cat-B上实现了新的最先进的性能。此外,在treci - qa和WikiQA上,我们的模型优于所有没有注意力机制的深层神经网络方法,如果不比依赖于注意力机制的方法更好的话,也是一个寓言。

1.介绍

文本匹配是自然语言处理(NLP)中各种任务的基础技术,如web搜索[1,2]、答案选择[3,4]、释义识别[5,6]等。以web搜索为例,给定一个查询和一组文档,需要一个匹配函数来确定查询文档对之间的关联分值,然后根据关联分值对所有文档进行排序。

大多数传统方法依赖于手工编写的特性和词汇资源,这些特性和词汇资源非常耗费人力,并且容易受到依赖解析[7]等语言工具的错误影响。近年来,深度神经网络(DNNs)以其良好的性能和较低的人工操作水平在文本匹配中得到了广泛的应用。很多款车型,比如DSSM [8], CDSSM[9],和ARC-I[10],关注文本表示,在整个文本(查询或文档)首先是由单个distributedvector通过款结构,以及查询的向量之间的相似度,然后计算文档匹配分数排名。通常,以表示为中心的模型不需要额外的数据,并且易于实现。然而,将复杂的文本压缩成单个向量将会产生结果.

在本地交互信息丢失的查询和文档[11]之间。为了解决这一问题,提出了ARC- II[10]、MatchPyramid[12]和DRMM[13]等文本内部交互模型。在这些模型中,查询词和文档词之间的内部交互首先被编码成相似矩阵,其中每个元素都包含一个本地匹配信号。然后将相似矩阵作为输入或注意输入到DNN中,学习最终的匹配分数

编码查询和文档之间的内部交互的一个有效方法是位置信息,它包括查询项出现的位置以及单词之间距离的依赖关系。该方法在基于邻域的信息检索模型中显示出很大的优势[14,15],并成功地将其引入DNN中进行文本匹配[11,16 - 18]。Wan等人[11]首先学习了句子在文本中出现位置的位置表示向量,然后用句子级位置向量生成一个交互张量进行匹配。Hui等人[17]使用逐词相似矩阵对词级位置信息进行建模,通过提取和聚合矩阵中的强词匹配信号,生成最终的匹配分数。Chen等人[16]假设查询词对其内蕴文本有影响,并将查询词对文本各位置的影响作为文本表示的交互信号嵌入其中。

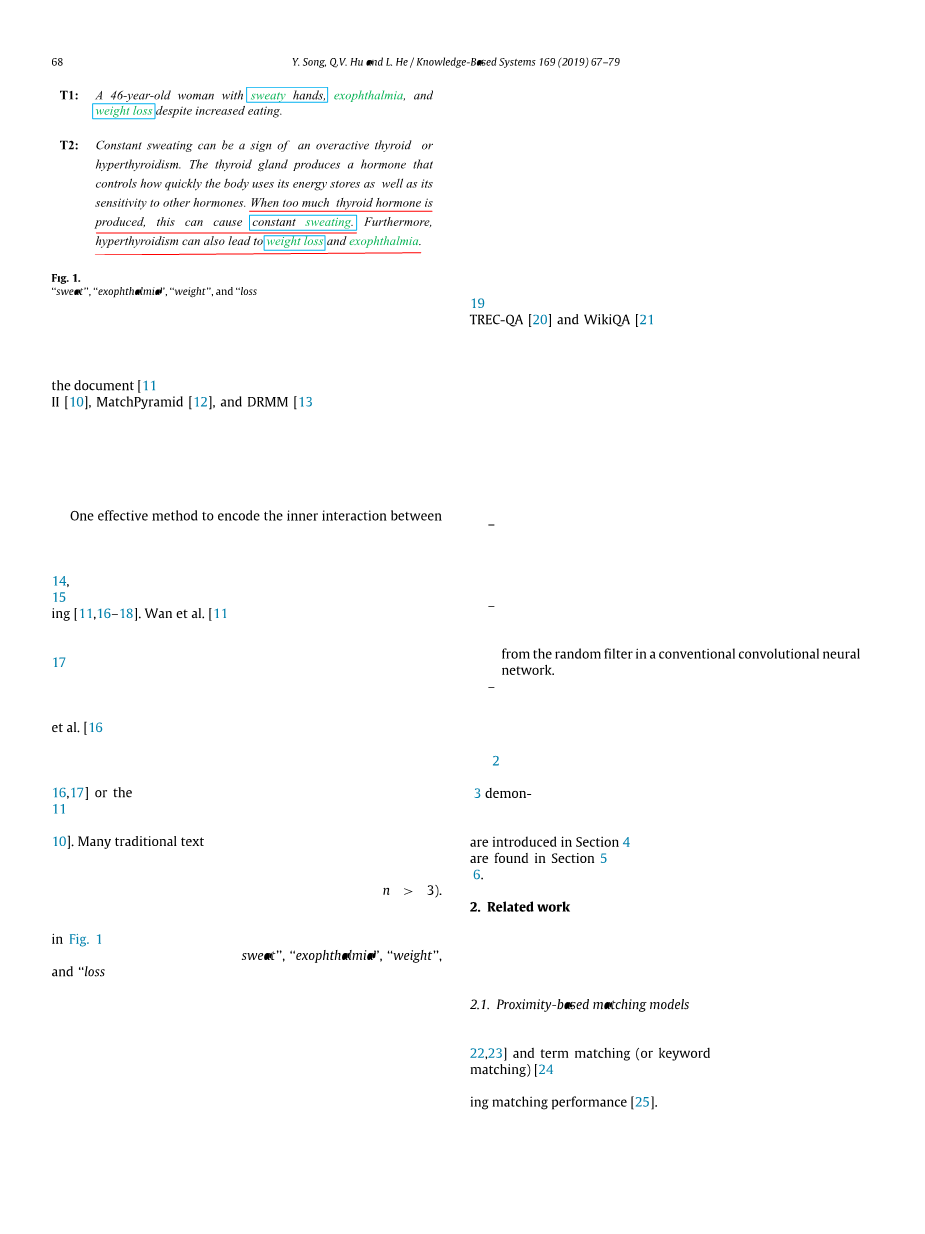

据我们所知,大多数关于位置神经网络的研究都集中在单词级别[16,17]或句子级别[11]。然而,一个文档的完整语义信息应该来自一个更复杂的结构,即顺序的和层次的[10]。许多传统的文本匹配方法都在不同粒度级别上对文本相似性进行建模,即单词级别(单字母)、短语级别(双字母、三字母)和句子级别(n字母、n gt; 3)。因此,我们认为在DNNs中,位置信息应该通过多角度来区分。以图1中的T1和T2为例,我们可以看到T1和T2中“流汗”、“眼球突出”、“体重”和“体重减轻”之间存在位置交互作用,这些位置交互作用从单词、短语和句子的角度触发位置模式。然而,如何定义和生成不同角度的位置信息,并将其嵌入到DNNs中作为文本匹配的局部交互信号,目前尚不清楚。

本文主要研究文本内部的相互作用,提出了一种基于位置卷积神经网络(P-CNN)的文本匹配算法。具体地说,我们首先将位置信息的视角定义为词语层面、短语层面和表象层面。然后采用位置相似映射层将字级位置信息投影到局部匹配信号中,弥补了嵌入输入层与隐藏卷积层之间的差距。在此基础上,提出了一种位置敏感卷积滤波器来捕获和提取短语级和句子级的语义信息。特别地,我们假设一个短语或句子对它的相邻短语或句子有影响,并且位置敏感的卷积滤波是在影响传播的基础上产生的,而不是传统卷积神经网络(CNN)中的随机矩阵。最后,我们提供了一个多视角匹配功能来聚合所有三个层次的位置信息。

为了评估提出的P-CNN方法的性能,我们针对两个著名的文本匹务:

ClueWeb-09-Category-B[19]用于Web搜索,treco - qa[20]和WikiQA[21]用

于选择答案,对三种不同大小和类型的标准TREC集合进行了广泛的实验。

其实, 实验结果表明,所提出的P-CNN模型具有良好的预测效果利用多视角位置信息进行文本相似度建模,明显优于经典的神经网络匹配模型。此外,与网络搜索的最新进展相比,我们在ClueWeb-09-Category-B上实现了最新的性能。在选择答案方面,我们的模型优于所有没有注意机制的DNN方法,即使不比依赖注意机制的方法更好,也可以与之媲美。

本文的主要贡献可以总结如下:

– 据我们所知,这是第一次尝试将位置信息从多个角度(即、词级、短语级 和句子级),并将它们与交互信号结合起来,在深层神经网络中进行文本配。

– 我们设计了一种位置敏感卷积滤波器,它能有效地检 测和提取卷积层中不同层次的位置信息,这与传统卷积神经网络中的随机滤波器有很大的

– 我们对网络搜索和答案选择两项匹配任务进行了广泛的实验,并对 实验结果进行了有益的、深入的分析,以促进进一步的研究

本文的其余部分组织如下。第二部分介绍了相关工作,包括传统的基于邻域的匹配模型和神经匹配模型。第三节论述了如何将语义匹配和术语匹配与树级位置信息连接起来。第4节介绍了实验装置的详细情况,第5节对实验装置进行了详细的分析和讨论。最后,我们在第六部分提出了我们的结论和未来研究的一些想法。

2.相关工作

在本节中,我们介绍了传统的基于近似的匹配模型和神经匹配模型的相关工作

2.1基于贴近度的匹配模型

传统的文本匹配可以分为两类:语义匹配[22,23]和术语匹配(或关键字匹配)[24]。然而,一个成功的匹配算法通常同时考虑这两个方面,这在提高匹配性能[25]方面被证明是有效的。

术语邻近性是将语义匹配和术语匹配信号相结合的一种方法。在这些模型中,一个术语的出现被假定对其邻近文本有影响。最先进的基于接近度的匹配模型[14,15,26,27]使用内核函数来估计术语影响分布。例如,Lv等人[14]提出了一个位置语言模型(position language model, PLM),他们为文档的每个位置定义了一个语言模型,并根据文档的PLMs得分对文档进行评分。PLM是根据通过预定义的内核函数在文档中传播的单词数来估计的。Zhao等人将交叉项定义为文档中的虚拟项,这是基于近似的匹配模型的另一个例子。交叉项发生在两个查询项相邻且它们的密度函数有交集时。通过将交叉项信息嵌入BM25模型,建立了检索文档的CRTER模型。该方法采用核函数计算交叉项的权值。

2.2神经匹配模型

DNNs最近在许多自然语言任务[28]中表现出了令人印象深刻的性能,如问题回答[29,30]、web搜索[31,32]和文本分类[33,34]。神经匹配模型与传统的匹配模型相结合,一般可分为两类:以表征为中心的匹配模型和以交互为中心的匹配模型。

以表征为中心的模型用于语义匹配;他们独立地学习每个查询和候选文档的表示,并计算两个具有相似函数的估计表示之间的相似度。例如,Huang等人提出了DSSM,这是一种以单词哈希阶段为第一层的前向神经网络,用于预测给定查询字符串和文档标题的点击概率。通过引入CNNs[9],进一步改进了DSSM模型。Wu等人利用bb0对用户和项目的描述,利用DNN对推荐系统进行双正则化矩阵分解。对于社区问题的回答,Zhou等人使用神经网络学习查询和答案的语义表示,考虑的是来自答案的信息,而不是给定查询的最佳答案。Tay等人[37]认为在学习单词级相似度评分时应该引入单词级方向性的概念,他们提出了一种双向长短时记忆的协同注意机制,使用复值内积对单词级相似度进行建模。

相反,面向交互的模型是为术语匹配而设计的,它基于查询和作为网络输入的候选文档之间的交互。例如,DeepMatch[38]将每个文本映射到一个术语序列,并训练一个前馈网络来计算匹配分数。自组织检索[13]的深度关联匹配模型是另一个以交互为中心的模型的例子,该模型向神经网络提供基于直方图的特征,这些特征表示查询和文档之间的操作。苏等人将词对齐作为源短语和目标短语之间的语义桥梁,提出了两种基于传统递归自编码的双语短语表示学习神经网络。Lee等人在CNN中使用了注意力机制(attention mech- anism)来识别有助于情绪分类的关键词。郑等人[41]观察到,具有相同关系的句子总是具有相似的表达方式,并提出了一种考虑这些术语依赖关系的长短时记忆(LSTM)网络关系提取方法。

位置信息,包括查询项出现的位置以及单词之间的距离依赖关系,是编码查询和文档之间的内部交互的有效方法[42,43],该方法已成功地引入DNN以进行匹配[11,16,17]。Wan等人首先学习了句子在文本中出现位置的位置表示向量,然后使用句子级位置向量vec- tors生成一个交互张量进行匹配。Hui等人利用词与词之间的相似性矩阵对词级位置信息进行建模,通过提取和聚集矩阵中的强词匹配信号,生成最终的匹配分数。Chen等人[16]假设查询词对相邻的文本有影响,并且单词对文本每个位置的影响作为文本表示的交互信号嵌入其中。此外,Pratama等人也证明了这些位置测量方法[44]的有效性,提出了一种基于元认知的脚手架分类器,其中认知成分中的规则前提由多元高斯函数支撑。

以往对神经网络的研究[45-47]表明,建立具有多级数据特征的神经网络是十分必要的。在[47]中,将一种在线特征选择机制嵌入到进化的模糊系统中,解决了数据不确定性、时间行为和系统无序的问题。Ive等人[46]采用了具有分层注意机制的递归递阶神经网络结构,提高了社交媒体文本分类的性能,表明分层特征在解决心理健康等实际问题上更为有效。Chen等人[45]将不同粒度的文本片段进行比较,形成一系列多通道相似矩阵,提出了一种多通道CNN用于文本匹配,这意味着句子结构是DNN模型中文本相似度建模的有用特征。此外,决策模型和核学习模型的实证研究也表明,在模型构建过程中考虑层次信息是有前景的[48-50]。

然而,大多数位置DNNs都侧重于基于词级匹配信号的位置信息建模,而在匹配分值生成过程中,文本之间的位置影响和多水平的相互作用尚未得到很好的研究。本文提出了一种新的位置卷积神经匹配模型,该模型从多个角度考虑了位置对文本匹配的影响和交互作用。

3.位置反褶积等n电网络

在本节中,我们详细介绍了用于文本匹配的位置卷积神经网络(P-CNN)。为了便于理解,我们首先简要介绍了传统的CNN模型和本文使用的一些符号。传统的CNN匹配模型(图2)基于不同滤波器的卷积层学习不同层次的特征,然后将这些特征与完全连通的层进行集成,得到最终的匹配分数。DNNs通常通过在查询和文档的末尾添加0来将输入查询和文档的长度填充为固定的数字。给定一个填充查询q = {q1, q2,hellip;, qn}和填充后的文档d = {d1, d2,hellip;, dm}, n, m分别是查询和文档中的单词数。qiisin;R t和djisin;R t分别表示单词qi和dj的嵌入表示,其中i = 1,2,hellip;, n, j = 1,2,hellip;, m, t是嵌入的维数。CNN的输入,表示X,可以问和d之间的相似矩阵在图2 X =问⨂d,⨂代表的交互操作。值得注意的是,交互操作符通常是一个逐字的相似函数,如cos相似度cos(qi,dj)。因此,相似矩阵的大小是一个常数,即ntimes;m

正式,假设X (l)是隐藏状态的激光强化层,Xcirc;(lminus;1)是输入的激光强化层,和b l的偏见是激光强化层。然后我们有卷积层和全连通层为:

其中W (l,lambda;)卷积过滤器的lambda;型激光强化层,lowast;表示卷积算子,f表示激活函数,和W(左)为第l个全连通层的权值矩阵。

通常,最后一个全连通层的输出是一个ctimes;1维矩阵,表示为X(L) = [X(L) 1, X(L) 2,hellip;x (L) c] T。对于排序任务,最终匹配分数可以是

其中g为Sigmoid函数,Wsis为1times;c维权矩阵。对于分类任务,最终的匹配分数或类别可以是

其中k是类别的标签,c代表类别的数量。

3.1 P-CNN框架

一个文档的完整语义信息应该来自一个更复杂的结构,即顺序的和层次的[10]。由于文本相似度的度量通常采用不同的交互粒度级别(即单词级、短语级和句子级)

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[18245],资料为PDF文档或Word文档,PDF文档可免费转换为Word

您可能感兴趣的文章

- 饮用水微生物群:一个全面的时空研究,以监测巴黎供水系统的水质外文翻译资料

- 步进电机控制和摩擦模型对复杂机械系统精确定位的影响外文翻译资料

- 具有温湿度控制的开式阴极PEM燃料电池性能的提升外文翻译资料

- 警报定时系统对驾驶员行为的影响:调查驾驶员信任的差异以及根据警报定时对警报的响应外文翻译资料

- 门禁系统的零知识认证解决方案外文翻译资料

- 车辆废气及室外环境中悬浮微粒中有机磷的含量—-个案研究外文翻译资料

- ZigBee协议对城市风力涡轮机的无线监控: 支持应用软件和传感器模块外文翻译资料

- ZigBee系统在医疗保健中提供位置信息和传感器数据传输的方案外文翻译资料

- 基于PLC的模糊控制器在污水处理系统中的应用外文翻译资料

- 光伏并联最大功率点跟踪系统独立应用程序外文翻译资料