使用循环帧生成的深度视频帧插值

关键词:循环一致性损失,运动线性损失,边缘引导训练

相关工作

本节回顾与这项工作相关的主题。我们首先描述了以往的视频帧插值方法,并将所提出的方法与它们进行了比较。接下来,我们回顾了循环约束的应用,提出了循环一致性损失的根源。

视频帧插值

传统方法(Baker et al. 2011;Werlberger等人,2011年;Yu et al. 2013)对于帧插值,通常通过立体匹配或光流预测估计连续帧之间的密集运动对应关系,并根据估计对应关系合成中间帧。这些方法继承了对应估计,导致了计算密集型的优化,效率较低。此外,这些方法倾向于在对象边界周围产生伪影。cnn在光流估计中已经被证明是有效的(Bailer, Taetz, and Stricker 2015;Dosovitskiy等人2015年;加朵与沃尔夫2016;Guney和Geiger 2016;Teney and Hebert 2016;Tran等人2016年;Weinzaepfel等人,2013)。这些基于cnn的流场预测方法需要以密集通信形式训练数据,而密集通信形式的训练数据很难标注。此外,基于光流的插值帧由于其目标是生成光流,因此常存在伪影。

一些帧合成方法利用cnn直接生成图像(Goodfellow et al. 2014)和视频(Vondrick, Pirsiavash,和Torralba 2016;Xue et al. 2016)。因此,他们没有使用密集的通信作为训练数据,而是使用基真中间帧。然而,这些方法仍然受到结果模糊和工件的影响。Liu等人(Liu et al. 2017)通过参考现有帧中像素的相干区域,并利用光流的网络层来解决结果模糊的问题。他们的方法使合成的画面更清晰,但伪影的问题仍未解决。其他方法(Niklaus, Mai, and Liu 2017a;2017b)将运动估计和帧合成结合到一个单一的卷积步骤。他们估计每个输出像素的空间变化的核,并将它们应用到输入帧进行帧插值。尽管这些方法是有效的,但它们需要特定于像素的核估计,并且消耗大量的计算能力和存储空间,特别是在高分辨率的帧合成中。

目前最先进的方法(Jiang et al. 2018;Niklaus和Liu 2018)利用CNN预测输入图像之间的双向光流,并利用另一个CNN模型基于预测的流合成插值图像。然而,这些方法要么需要额外的训练数据来进行光流估计,要么需要大量的训练时间。

不像大多数现有的方法,通过设计更强大的深度特性或架构来增强帧间极化,我们的方法通过利用两个扩展的周期一致性损失来减轻前面提到的back。我们的方法有三个优点。首先,我们的方法通过解决模糊的结果和人为因素的问题,实现了超越现状的性能。其次,虽然现有的方法需要更多的训练数据来学习强大的特征或网络,但我们的方法对于训练数据不足的问题更具鲁棒性。第三,使用循环一致性损耗不会增加模型参数。因此,训练和推理成本几乎保持不变。这些优良的特性将我们的方法与之前的工作区别开来。

周期约束

使用循环约束正则化结构化预测已在文献中进行了探索。对于语言翻译来说,使用反向翻译和调和(Brislin 1970)可以有效地提高翻译质量。对于视觉跟踪,加强前后一致性有助于达到更好的结果(Sundaram, Brox, and Keutzer 2010)。高阶循环一致性已被用于不同的视觉任务,如运动中的结构(Zach, Klopschitz,和Pollefeys 2010)、3D形状匹配(Huang和gubas 2013)、共分割(Wang, Huang,和gubas 2013)、密集语义对齐(Zhou等人2015;2016)、深度估计(Godard, Mac Aodha, and Brostow 2017)和图像到图像的翻译(Zhu et al. 2017)。对于深度学习,研究努力(Zhou等人2016;2017年,戈达尔、Mac Aodha和Brostow;Zhu et al. 2017)利用循环一致性的概念来正则化深度模型的训练。

据我们所知,这项工作是利用周期一致性来改进视频帧插值的第一次尝试。我们设计了一个两阶段的优化程序,使两个映射方向在循环约束下共享插值模型能够稳定地学习。结果表明,我们的方法可以在不引入额外可学习参数的情况下大大提高插值的质量。此外,通过考虑应用特定的知识,扩展了循环一致性的概念,可以解决大运动或丰富纹理区域的性能下降问题。

建议的方法

给定一组训练数据,每个训练数据是包含三个连续视频帧的三元组,我们的目标是学习一个深度模型,该模型以两个连续帧作为输入,可以预测其高质量的中间帧。将学习到的模型应用于视频的所有连续帧,使其帧速率加倍。重复应用该模型k次,帧速率将提高2^k倍。例如,给定输入帧,我们的模型首先生成2times;插值帧。然后将其再次应用于Scup;Srsquo;,得到4times;插值。

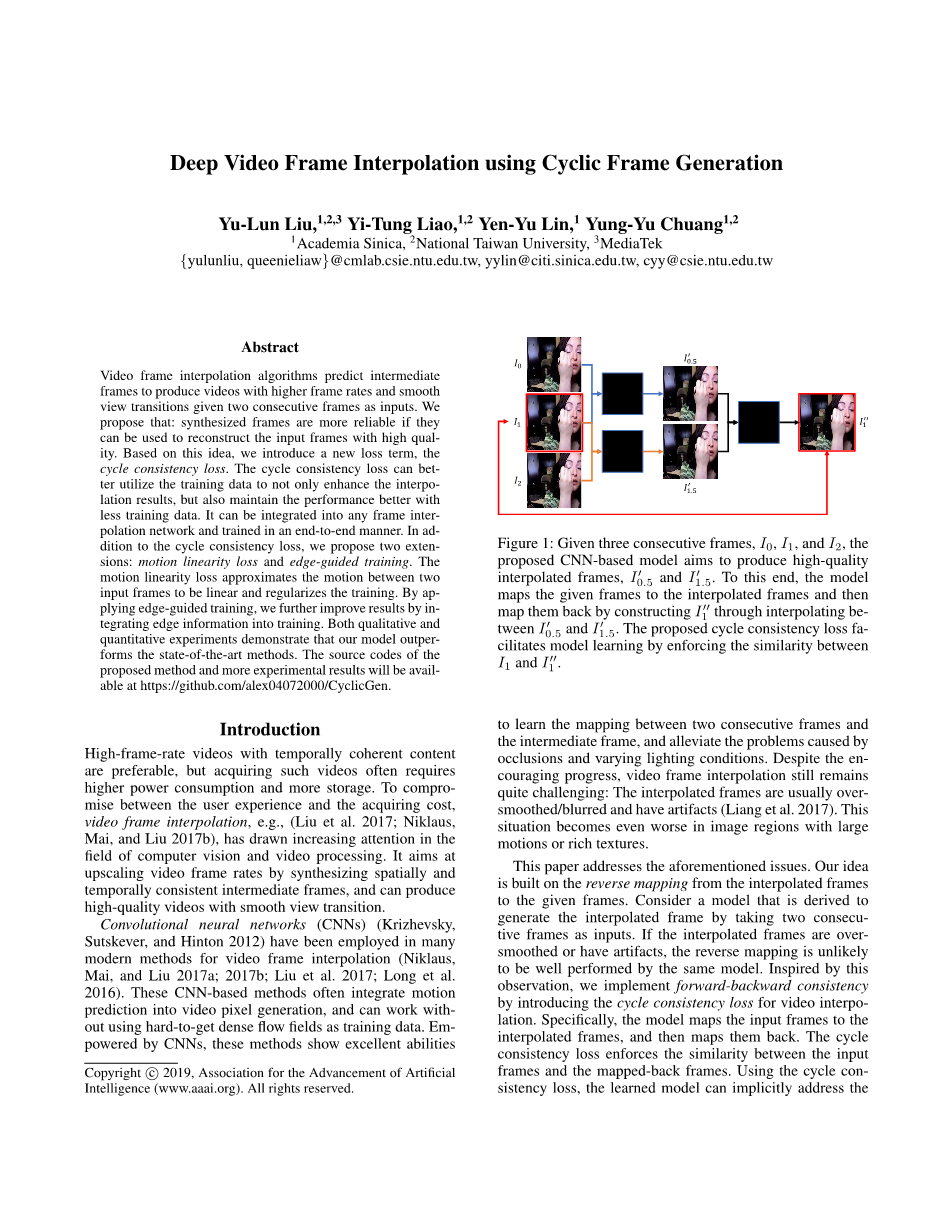

我们的方法实现了一个两阶段的训练过程。其网络架构如图2所示。我们的方法有三个新提出的分量,即周期一致性损失、运动线性损失和边缘引导训练。循环一致性损耗使得模型能够生成可信的中间帧,从而使这些中间帧能够用于反向重建给定的帧。运动线性损失正则化了训练中运动的估计。边缘引导训练有助于保持边缘结构。我们将在下面描述这三个组成部分。

周期一致性损耗Lc

传统的损失函数,如l1范数损失,在评估插值帧的质量时,并不完全符合人类的感知。最小化l1范数损失通常会导致过度平滑的帧或伪影,如图3(a)和3(b)所示,因为这些不利的影响只会略微增加损失。考虑到过平滑的插值帧在使用相同的插值模型时不能很好地重构出原始帧,我们提出了周期一致性损耗Lc,以保证逆帧生成的质量,即以插值帧为输入生成原始帧。这样,可以利用循环一致性损失隐式地缓解这些不利影响,如图3(c)所示。

考虑一种基线插值模型,该模型以两帧连续的数据作为输入,合成它们之间的中间帧。基线模型可以应用于训练集D中的每一个三元组n, (In,0, In,1, In,2),其中In,0, In,2为输入,In,1为期望输出。由于每个三元组都作为模型的输入,在本文中,为了简洁,我们有时会省略索引n。现有的几种方法,如AdaConv (Niklaus, Mai, and Liu 2017a)和SepConv (Niklaus, Mai, and Liu 2017b)可以作为基线模型。在本工作中,我们选择deep voxel flow (Liu et al. 2017)作为基线,因为它简单且性能良好。该模型通过使用预测的流图和掩模对输入帧进行扭曲,学会从输入帧合成中间帧。详见DVF (Liu et al. 2017)的原始论文。

为了稳定地将循环一致性损失集成到模型学习中,并且不增加模型中可学习参数的数量,我们开发了一个两阶段的训练过程。在第一阶段,每个训练三联体使用l1-范数损失Lr学习基线模型,其中r代表重建,即:

(1)

其中f为基线模型。

在第二阶段,我们将预训练的模型f复制了三次,如图2所示,以引入循环一致性损失。对于一个三元组(I0, I1, I2),前两个复制模型分别以(I0, I1)和(I1, I2)为输入,生成中间帧Irsquo; 0.5和Irsquo; 1.5,作为第三个复制模型的输入,生成重构后的I1,即irsquo;rsquo;1。循环一致性损耗使输入帧I1和重构帧Irsquo;rsquo;1之间的差异最小化。具体来说,共享基线模型f和它的三个重复的对应部分的可学习参数。第二阶段,对四个权重共享模型进行端到端训练,目标函数如下:

(2)

其中 Irsquo;rsquo; n,1 = f(Irsquo; n,0.5 , Irsquo; n,1.5 ), Irsquo;n,0.5 = f(In,0, In,1) 和Irsquo; n,1.5 = f(In,1, In,2)分别为三种共享权模型生成的帧。

运动线性损耗

运动剧烈的区域会引起剧烈的外观变化。因此,在这些区域进行插值是相当困难的。为了解决这个问题,我们假设两个连续帧之间的时间间隔足够短,从而使两帧之间的运动是线性的。在大多数情况下,这种假设有助于减少运动的不确定性,并减轻近似误差。

在此基础上,提出了运动线性损耗Lm,以一种自监督的方式正则化光流估计。在两阶段训练过程中,第一阶段连续帧之间的时间间隔是第二阶段的两倍。在运动线性假设下,第一阶段预训练的模型产生的流场大小是第二阶段复制模型的两倍。

在图2中,蓝色块表示应用运动线性损失Lm的估计流图。具体来说,这种损失由

(3)

其中F为流图,下标为流图的数据索引和流图输入帧的时间间隔。

边导训练E

在高纹理区域上进行插值是很困难的。为了验证这一观察结果,如图4所示,我们应用了DVF模型(Liu et al. 2017),并使用metric,均方误差(MSE)来评估其在(Liu et al. 2017)收集的测试集上的性能。通过均匀划分梯度幅度的间隔,我们根据像素的梯度幅度将其划分为10个bins。图4(a)和图4(b)分别显示了每个bin的梯度幅值直方图和插值误差。可以观察到,梯度较大的像素往往有较大的误差。受到这一观察的启发,我们实现了边缘引导训练E,将边缘信息加入到模型的输入中,通过保持边缘结构来改进帧插值。

为了计算图像的边缘映射,我们尝试了几种算法,包括(Canny 1986;卡诺普洛斯,瓦桑塔瓦达和贝克1988年;马尔和希尔德雷思1980年;Xi和Tu 2015)。我们最后使用基于cnn的模型,全嵌套边缘检测(HED) (Xie和Tu 2015),因为它的性能。此外,通过使用基于cnn的HED,我们的方法保持端到端可训练。如图2所示,我们通过HED获得了两个输入帧到模型f的边缘映射,并将它们作为模型输入的一部分进行扩充。

实现细节

我们的方法建立在DVF (deep voxel flow)模型(Liu et al. 2017)的基础上,并与之共享相同的设置。DVF使用CNN模型来估计连续两帧之间的运动,并从两帧中复制相应的像素来重建中间帧。优化分两个阶段进行,目标函

剩余内容已隐藏,支付完成后下载完整资料

英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[596210],资料为PDF文档或Word文档,PDF文档可免费转换为Word

您可能感兴趣的文章

- 饮用水微生物群:一个全面的时空研究,以监测巴黎供水系统的水质外文翻译资料

- 步进电机控制和摩擦模型对复杂机械系统精确定位的影响外文翻译资料

- 具有温湿度控制的开式阴极PEM燃料电池性能的提升外文翻译资料

- 警报定时系统对驾驶员行为的影响:调查驾驶员信任的差异以及根据警报定时对警报的响应外文翻译资料

- 门禁系统的零知识认证解决方案外文翻译资料

- 车辆废气及室外环境中悬浮微粒中有机磷的含量—-个案研究外文翻译资料

- ZigBee协议对城市风力涡轮机的无线监控: 支持应用软件和传感器模块外文翻译资料

- ZigBee系统在医疗保健中提供位置信息和传感器数据传输的方案外文翻译资料

- 基于PLC的模糊控制器在污水处理系统中的应用外文翻译资料

- 光伏并联最大功率点跟踪系统独立应用程序外文翻译资料