用于压缩视频增强的解码器端交叉分辨率合成

关键词:视频编码,交叉分辨率合成,超分辨率,深度学习

概述

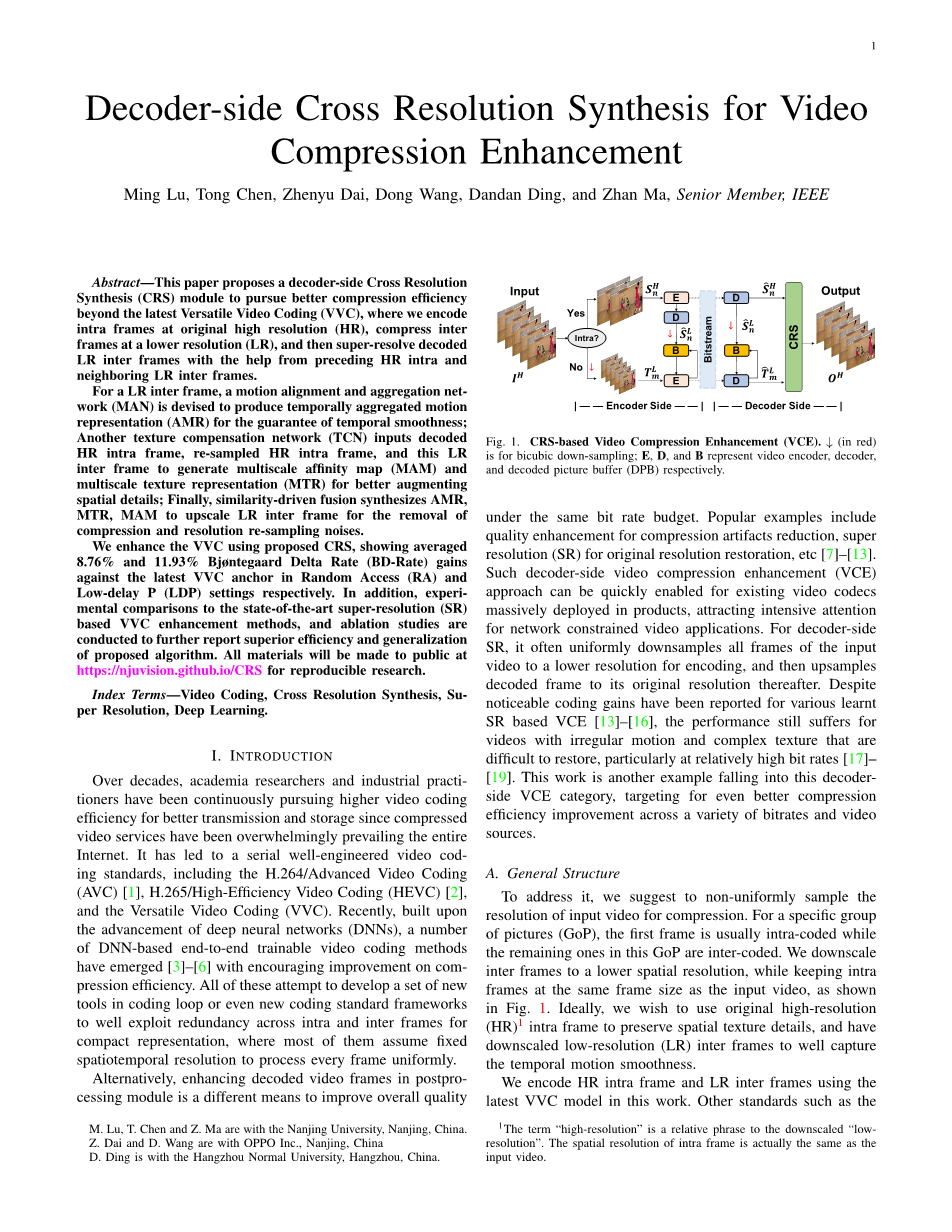

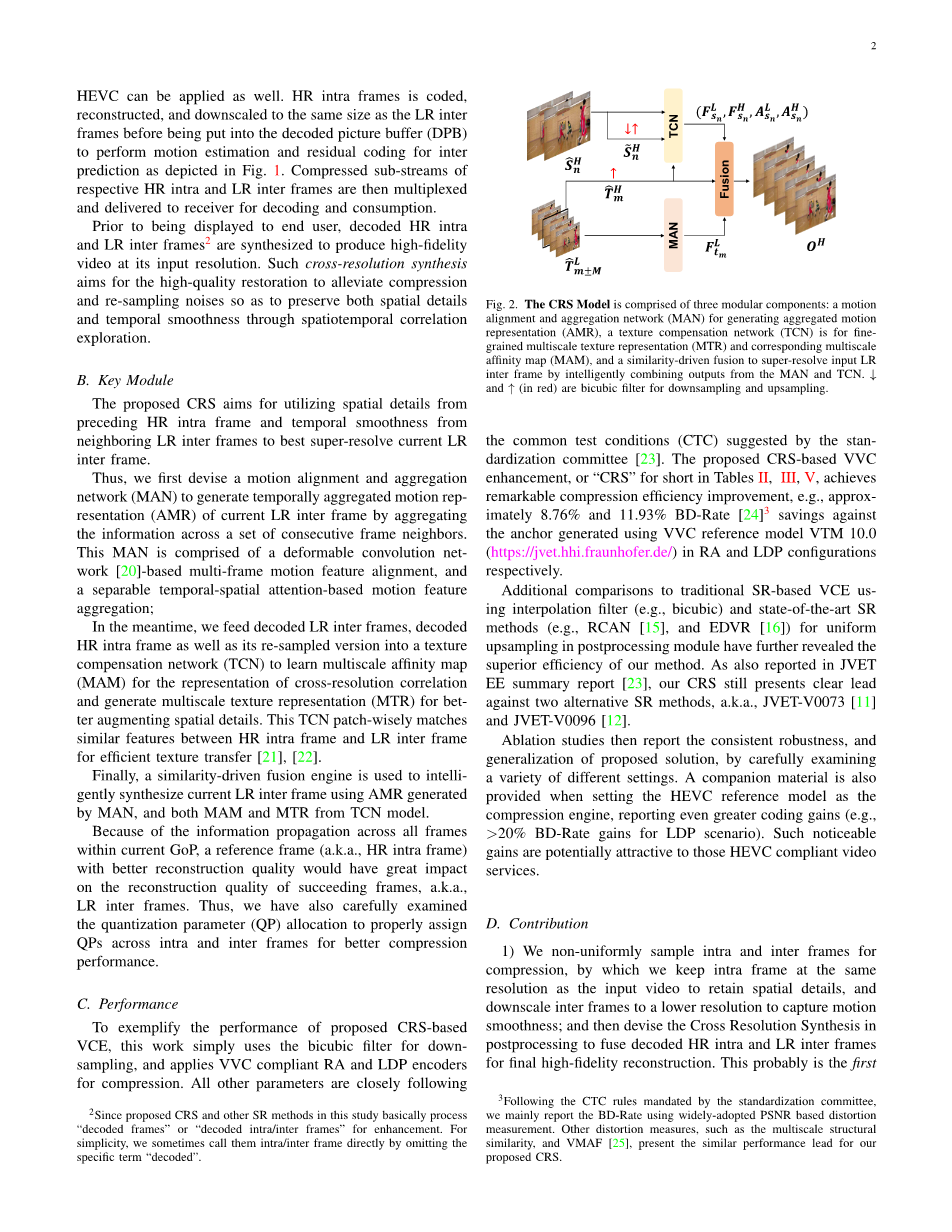

理想情况下,我们希望恢复由公式(5)中的压缩和重新采样引起的高频分量损失。在我们的方法中,我们尝试利用多个时间上相邻帧来提高恢复质量并保证所有超分辨率的LR帧间帧的时间运动平滑度;同时,我们还希望将重建的高分辨率(HR)帧内帧的空间细节大大增强来减轻低分辨率(LR)帧间帧的这种损失。因此,背后的关键问题是如何智能地结合时间运动特征和空间纹理特征来更好地超分辨率LR帧间帧。 在实践中,我们将这种整体CRS优化分解为三个模块化函数,如图2所示。具体来说,我们利用MAN模型,使用其LR相邻帧以及自身来对齐和聚合特定LR帧间帧的时间运动特征,即

(7)

同时,我们建议另一个TCN模型来表征多尺度亲和映射(纹理相关性或相似性)和多尺度纹理表示(MTR)来补偿,通过输入解码的HR帧内帧、重采样的HR帧内帧,以及当前LR帧间帧的放大版本,例如

(8)

最后,我们利用相似性驱动的融合,通过适当地权衡上述时空信息,将输入合成到其放大的输出,即有

(9)

本质上,方程式中所示的这种交叉分辨率合成。可以很容易地扩展到支持任何编码结构和任何数量的相邻帧,例如仅使用前面几个相邻帧的低延迟场景。

运动对齐和聚合网络 (MAN)

为了保证时间上的平滑度并且同时利用相邻帧来更好的对低分辨率帧间帧进行超分辨率,需要准确地刻画相邻帧之间的运动动态。整个过程通常包括特征对齐和聚合,如图3所示。

对齐:我们已经知道多帧运动特征通常用于时间上的对齐,我们设置M = 1,除了当前之外,还有当前帧的前一帧和后一帧,用于组成3帧的时间窗口缓冲区。其他类型的时间窗口缓冲区也可以被轻松支持,例如仅使用前面的相邻帧,甚至更多数量的相邻帧等。

首先,设计一个由4个连续残差块组成的共享权重的特征提取模块,用来生成该时间窗口缓冲区每个帧的深度特征表示。在整个工作中,卷积层的内核大小固定为3times;3。由于我们的任务是将相邻的帧向当前的低分辨率帧间帧对齐,因此其余过程通常在帧(或特征)对上运行,其中一个是当前帧(或当前帧的深层特征),另一个是时间窗口缓冲区中的一个特定帧(或该特定帧的深层特征)。

当前帧和一个特定帧的深度特征被级联并送到一个多尺度网络 (MSN),该网络由几个残差块组成,用于生成它们之间逐通道的时间偏移。通过部署这种多尺度模型架构,我们可以获得更准确的时间偏移,以表示特征域中的逐帧运动位移。对于使用当前帧及其相邻帧得出的偏移量,我们称其为跨邻时间偏移量。对于使用当前帧及其本身计算的偏移量,我们称其为自包含时间偏移量。

随后,对于当前帧和来自时间窗口缓冲区的另一帧之间的对齐时间特征可以通过将该帧的深度特征和相应的学习到的和该帧之间的多尺度时间偏移输入到可变形卷积网络(DCN)中得到。尽管光流可能适合这项任务,但它很容易受到压缩噪声的影响。因此我们选择在这项工作中使用DCN。然后,按照相同的过程,我们迭代地对齐当前帧和时间窗口缓冲区中的每个帧(例如相邻帧和当前帧本身),生成T个对齐的时间特征堆栈,每个特征堆栈的大小为Htimes;Wtimes;C。 对于当前帧及其相邻帧的帧对,它们的对齐时间特征称为相邻对齐时间特征。而对于具有当前帧及其本身的帧对,称为自对齐的时间特征。T是滑动时间窗口缓冲区中的总帧数。如图3所示,T = 2M 1 = 3,通道维度C为64并且在本项目中保持不变,H和W是原始输入视频的高度和宽度。

聚合:然后,我们应用基于注意力的机制,通过依次执行可分离的时间注意力(TA)和空间注意力(SA)聚合,有效地处理多个对齐的时间特征堆栈。

如图3所示,这样的T个对齐时间特征堆栈分别描述了当前帧和滑动时间窗口中的一帧的对齐信息。然后在自对齐时间特征和其他相邻对齐时间特征的卷积表示上应用点积,计算对齐的时间特征的相似距离映射。通过将输入数据转换到另一个特征空间(例如较少通道的)以简化计算,这种方法已广泛用于注意力网络。通过在派生的相似距离映射上进一步应用sigmoid激活函数,我们可以得到时间注意掩码,然后将其按元素与相邻对齐的时间特征相乘,以获得TA优化的时间特征。类似的过程迭代地应用于具有一个自对齐时间特征堆栈和另一个相邻对齐时间特征堆栈的其他特征对。之后,所有TA优化的时间特征被级联在一起并进行卷积以进行后续的空间注意力优化。

在SA步骤中,我们移除了最大池化层并使用 MSN(参见图 3 中的 SA 框)以及 sigmoid 激活来生成空间注意掩码,并且不会丢失通道信息。此后,空间注意掩码也与所有TA优化的时间特征的卷积串联相乘以产生当前帧的最终聚合运动表示,大小为Htimes;Wtimes;C。毕竟,该表示有望携带足够且必要的时间上的信息,这些信息通过彻底分析此时间窗口缓冲区中所有帧的时间动态来获取,用来更好的超分辨率。

这种基于可变形卷积的对齐和基于注意力的聚合可以很好地捕捉使用金字塔特征的多帧时空动态。它还可以克服许多基于光流的方法无法很好处理的具有挑战性的问题,例如噪声、遮挡、大运动位移等。

纹理补偿网络 (TCN)

用于恢复解码的低分辨率帧间帧的空间纹理细节,可以使用可变形卷积或基于光流的变形将高分辨率帧内帧向当前帧间帧对齐,用于帮助超分辨率重建。然而,当HR帧内帧和相关LR帧间帧的帧距离增加时,对齐效率急剧下降,LR帧间帧的恢复质量也随之降低。相反,最近的纹理转移方法的启发,我们引入了一个纹理补偿网络(TCN),该网络采用补丁明智的匹配来测量 HR 帧内和当前的LR帧间,用于细粒度和鲁棒的纹理传输。该TCN旨在进一步提高当前LR帧间的恢复质量,其基本由产生多尺度特征表示、特征域相关性测量和多尺度空间纹理特征三个处理阶段组成;

阶段 1 - 多尺度特征表示:理想情况下,我们希望将清晰的纹理从解码的HR帧内转移到当前放大的LR帧间帧以获得更好的质量,为此我们需要仔细检查它们的相关性并选择最合适的局部补丁补偿。请注意,放大的LR帧间帧是从其LR版本放大而来的。为了减轻可能来自上采样操作的噪声的影响,我们建议将解码的HR帧内帧重新采样为以进行相关性测量。

我们希望使用那些能更好地表征细粒度空间纹理动态的多尺度特征代表来捕捉相关性,而不是直接执行像素域计算。为了实现这一目标,我们使用共享权重的多尺度特征提取 (MFE) 模块中,该模块由四个残差块和两个步长为 2 的卷积层组成。一组不同尺度的多尺度特征,即Value、Key和Query,分别为HR帧内帧、重采样的HR帧内帧和HR帧间帧生成,如图4所示(阶段1)。

阶段2 - 特征域相关性测量:然后我们使用Query和Key之间的亲和度计算来定义相关性测量。正如我们广泛的研究所揭示的那样,在最小尺度(例如在Htimes;Wtimes;C的大小)上利用各自的Query和Key特征,也就是Q和K,不仅可以提供几乎相同的性能而没有明显的降级,并且大大减少了计算量。因此,我们使用各自Query和Key的最小尺度特征Q和K进行相关推导(例如亲和映射,位置映射)。这些相关度量对应于最小尺度Q和K,因此它们可以直接用于从Value的最小尺度分量(例如V)中检索补丁,以进行补偿。

由于特征图中的每个元素点很难描述目标区域的局部信息,因此逐点亲和力测量可能会出现问题。因此,如图4(第2阶段)所示,例如h = w = 3,用于横向所有特征元素并将特征图K和Q展开为大小为 [h,w,c]。K的每个块ki可以重新整形为大小为[1, chw]的向量,类似地,Q的块qi也可以重新整形为大小为[1, chw]的向量。这里,i, jisin;[1, H/4times;W/4 ]。

为了充分表征相关性,我们计算归一化余弦相似度以非局部方式生成亲和映射:

(10)

其中 ai,j 表示块 ki 和 qj 之间的相关性。 因此,对于Q中的每个qj,K中最相关的块ki具有最大相关系数

(11)

并且K中最佳ki的位置是

(12)

最后,我们可以构建尺寸为[1, Htimes;W]的亲和力映射和它相关的优化块位置映射来代表K和Q之间最相关的块通过级联每个qj的(11)中优化的ai和(12)中的pai。

阶段3 - 多尺度空间纹理特征:根据上述讨论,我们可以利用亲和力映射和优化块位置映射从HR帧内的最小尺度特征V中检索最合适的块,以进行纹理补偿。例如我们使用优化块位置映射重新组织输入V的块,以构建尺寸为[H,W]的最小尺度纹理特征(参见图4(阶段3))。

此外,我们希望使用Value的全谱特征来最好地补偿LR帧的空间频率损失。另一方面,我们必须保持最佳位置映射的默认大小,否则可能会由于不正确的检索位置而引入混叠或意外错误。因此,对于Value超出最小尺度的纹理特征,我们分别应用步长为2和4的折叠和展开操作,通过这些操作我们可以准确地将位置与优化块位置映射对齐。在展开步骤,我们直接从特征图中提取元素;而在相反的折叠步骤中,我们插入卷积以获得更好的信息嵌入。最终,我们将分别得到FLsn和FHsn,以形成多尺度纹理表示 (MTR)。

同时,我们对水平和垂直维度分别以2和4的因子对Asn进行双线性插值,以使ALsn和AHsn在另外两个尺度上与Value的纹理特征匹配,从而构建多尺度亲和映射。

外文原文资料信息

[1] 外文原文作者:Ming Lu, Tong Chen, Zhenyu Dai, Dong Wang, Dandan Ding, and Zhan Ma

[2] 外文原文所在书名或论文题目:Decoder-side Cross Resolution Synthesis for Video Compression Enhancement

[3] 外文原文来源:

出版社或刊物名称、出版时间或刊号、译文部分所在页码:IEEE/2022/4-7页

网页地址:https://ieeexplore.ieee.org/document/9681152

二、外文原文资料:

times;times;times;times;times;COMPRESSIONtimes;times;times;times;times;

Decoder-side Cross Resolution Synthesis for Video Compression Enhancement

Keywords: Video Coding, Cross Resolution Synthesis, Super Resolution, Deep Learning

A. Overview

Ideally, we wish to restore high-frequency component loss induced by the compression and re-sampling in (5). In our approach, we attempt to leverage multiple temporal frame nei

剩余内容已隐藏,支付完成后下载完整资料

英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[596201],资料为PDF文档或Word文档,PDF文档可免费转换为Word

您可能感兴趣的文章

- 饮用水微生物群:一个全面的时空研究,以监测巴黎供水系统的水质外文翻译资料

- 步进电机控制和摩擦模型对复杂机械系统精确定位的影响外文翻译资料

- 具有温湿度控制的开式阴极PEM燃料电池性能的提升外文翻译资料

- 警报定时系统对驾驶员行为的影响:调查驾驶员信任的差异以及根据警报定时对警报的响应外文翻译资料

- 门禁系统的零知识认证解决方案外文翻译资料

- 车辆废气及室外环境中悬浮微粒中有机磷的含量—-个案研究外文翻译资料

- ZigBee协议对城市风力涡轮机的无线监控: 支持应用软件和传感器模块外文翻译资料

- ZigBee系统在医疗保健中提供位置信息和传感器数据传输的方案外文翻译资料

- 基于PLC的模糊控制器在污水处理系统中的应用外文翻译资料

- 光伏并联最大功率点跟踪系统独立应用程序外文翻译资料